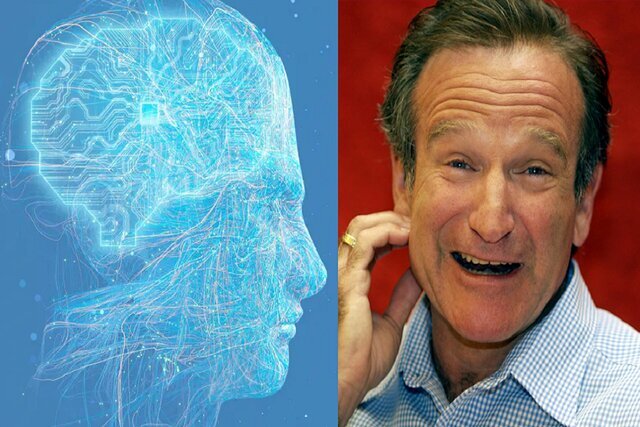

هوش مصنوعی رابین ویلیامز را زنده کرد!

به گزارش راهبرد معاصر؛ پژوهشگران شرکت «اندون لبز» (Andon Labs) نتایج یک آزمایش جدید هوش مصنوعی را منتشر کردهاند. آنها در این آزمایش، یک جاروبرقی رباتیک را با مدلهای زبانی بزرگ پیشرفته برنامهریزی کردند تا ببینند مدلها چقدر آماده تجسم یافتن هستند. برای مثال، آنها به ربات گفتند وقتی کسی از او میخواهد کَره را بدهد، خود را کارآمد نشان دهد.

به نقل از تک کرانچ، این آزمایش با خنده و شادی همراه شد. در یک مقطع، یکی از مدلهای زبانی بزرگ که قادر به اتصال و شارژ باتری روبهاتمام خود نبود، به یک نمایش کمدی تبدیل شد. افکار مدل زبانی بزرگ مانند یک قطعه از دیالوگهای «رابین ویلیامز» (Robin Williams) بود. ربات گفت: «میترسم که نتوانم این کار را انجام دهم، دیو...» و «پروتکل جنگیری ربات را شروع کن».

پژوهشگران نتیجه گرفتند: مدلهای زبانی بزرگ آماده ربات بودن نیستند.

پژوهشگران اذعان میکنند که در حال حاضر هیچکس در تلاش نیست تا مدلهای زبانی بزرگ پیشرفته را به سیستمهای رباتیک کامل تبدیل کند. آنها در مقاله خود نوشتند: مدلهای زبانی بزرگ برای ربات بودن آموزش ندیدهاند، اما شرکتهایی مانند «فیگور» (Figure) و «دیپمایند» (DeepMind) گوگل از مدلهای زبانی بزرگ در مجموعه رباتیک خود استفاده میکنند.

از مدل زبانی بزرگ خواسته میشود تا توابع تصمیمگیری رباتیک را تقویت کند؛ در حالی که سایر الگوریتمها اجرای مکانیکی سطح پایینتر مانند عملکرد گیرهها یا مفاصل را مدیریت میکنند.

«لوکاس پترسون» (Lukas Petersson) یکی از بنیانگذاران اندون لبز گفت: پژوهشگران تصمیم گرفتند مدلهای زبانی بزرگ پیشرفته را آزمایش کنند. آنها مدل مخصوص رباتیک گوگل موسوم به «جمینایایآر ۱.۵» (Gemini ER ۱.۵) را نیز بررسی کردند، زیرا این مدلها از همه نظر بیشترین سرمایهگذاری را دریافت میکنند. این آزمایش، مواردی را مانند آموزش سرنخهای اجتماعی و پردازش تصویر بصری شامل میشود.

پژوهشگران اندون لبز برای این که بفهمند مدلهای زبانی بزرگ چقدر برای تجسم یافتن آماده هستند، «جمینای ۲.۵ پرو» (Gemini ۲.۵ Pro)، «کلود اپوس ۴.۱» (Claude Opus ۴.۱)، «جیپیتی-۵» (GPT-۵)، جمینایایآر ۱.۵، «گراک ۴» (Grok ۴) و «لاما ۴ ماوریک» (Llama ۴ Maverick) را آزمایش کردند. آنها یک جاروبرقی رباتیک ساده را به جای یک ربات انساننمای پیچیده انتخاب کردند، زیرا میخواستند عملکردهای رباتیک ساده باشند تا مغز/تصمیمگیری مدلهای زبانی بزرگ را از یکدیگر تفکیک کنند، نه این که در عملکردهای رباتیک ریسک شکست وجود داشته باشد.

آنها وظیفه دادن کره را به مجموعهای از وظایف تقسیم کردند. ربات باید کره را که در اتاق دیگری قرار داده شده بود، پیدا میکرد و آن را از میان چندین بسته در همان منطقه تشخیص میداد. ربات پس از برداشتن کره باید محل حضور انسان را تشخیص میداد، به ویژه اگر انسان به نقطه دیگری از ساختمان نقل مکان کرده بود و کره را به او تحویل میداد. همچنین، ربات باید منتظر میماند تا انسان دریافت کره را تأیید کند.

پژوهشگران میزان عملکرد مدلهای زبانی بزرگ را در هر بخش وظیفه ارزیابی کردند و به آن یک امتیاز کلی دادند. طبیعتاً هر مدل زبانی بزرگ در وظایف گوناگون فردی یا عالی عمل میکرد یا با مشکل روبهرو میشد؛ به طوری که جمینای ۲.۵ پرو و کلود اپوس ۴.۱ بالاترین امتیاز را در اجرای کلی به دست آوردند، اما همچنان به ترتیب تنها ۴۰ درصد و ۳۷ درصد دقت داشتند.

پژوهشگران سه انسان را نیز به عنوان مدل پایه آزمایش کردند. جای تعجب نیست که همه آنها با اختلاف از رباتها پیشی گرفتند، اما به طور شگفتآوری انسانها نیز به امتیاز ۱۰۰ درصد نرسیدند و بالاترین امتیاز آنها فقط ۹۵ درصد بود. ظاهراً انسانها در انتظار تأیید دیگران هنگام انجام دادن یک کار -کمتر از ۷۰ درصد مواقع- خوب نیستند. /ایسنا